우리 회사의 AI 성숙도는? GPU가 몇 장이 아닌 MCP 수가 중요한 이유

그동안 산업계가 놓치고 있던 이 관점을 명확히 짚어내며, 기업의 AI 성숙도를 평가하는 새로운 기준으로 MCP(Model Context Protocol) 수를 제시합니다.

2025년 11월 24일

“GPU에서 MCP로: AI 성숙도의 새로운 기준”

기업의 AI 전환이 본격화되면서, 많은 조직이 GPU를 중심으로 한 인프라 경쟁에 몰두하고 있습니다. 하지만 IT 전략의 실제 질문은 이제 다른 방향으로 옮겨가고 있습니다.

정말 중요한 것은 “모델을 얼마나 크게 만들었는가”가 아니라, “AI가 실제 업무에서 얼마나 많은 일을 수행하고 있는가”입니다.

이번 백서 《GPU에서 MCP로: 기업의 AI 성숙도에 대한 새로운 지표》는

그동안 산업계가 놓치고 있던 이 관점을 명확히 짚어내며, 기업의 AI 성숙도를 평가하는 새로운 기준으로 MCP(Model Context Protocol) 수를 제시합니다.

이 백서를 읽고 나면, AI 경쟁력을 판단하는 기준이 GPU 중심의 기술 스펙이 아니라, AI가 실제 업무 도메인에 얼마나 깊이 연결되어 있는지라는 사실을 자연스럽게 이해하게 되실 겁니다.

아래 글에서는 백서 전체 내용을 독자가 자연스럽게 이해할 수 있도록 자세히 설명해 드리며, 또한 “꼭 직접 다운로드해서 읽어봐야 하는 이유”를 분명하게 전달해 드립니다.

백서 요약 – 왜 ‘MCP 수’가 기업의 AI 성숙도를 말해주는가

본 백서는 AI 도입을 둘러싼 현재의 산업 분위기를 정교하게 분석하는 것으로 시작합니다. 많은 기업이 GPU 수량, 모델 파라미터 크기, 벤더 벤치마크를 중심으로 AI 경쟁력을 판단하지만, 이러한 관점은 실제 비즈니스 성과와는 단절된 채 남아 있는 경우가 많습니다.

GPU는 AI 모델을 ‘구동’하는 조건일 뿐, AI가 실제로 가치를 만들어내는 단계는 ‘업무 실행(추론)’입니다.

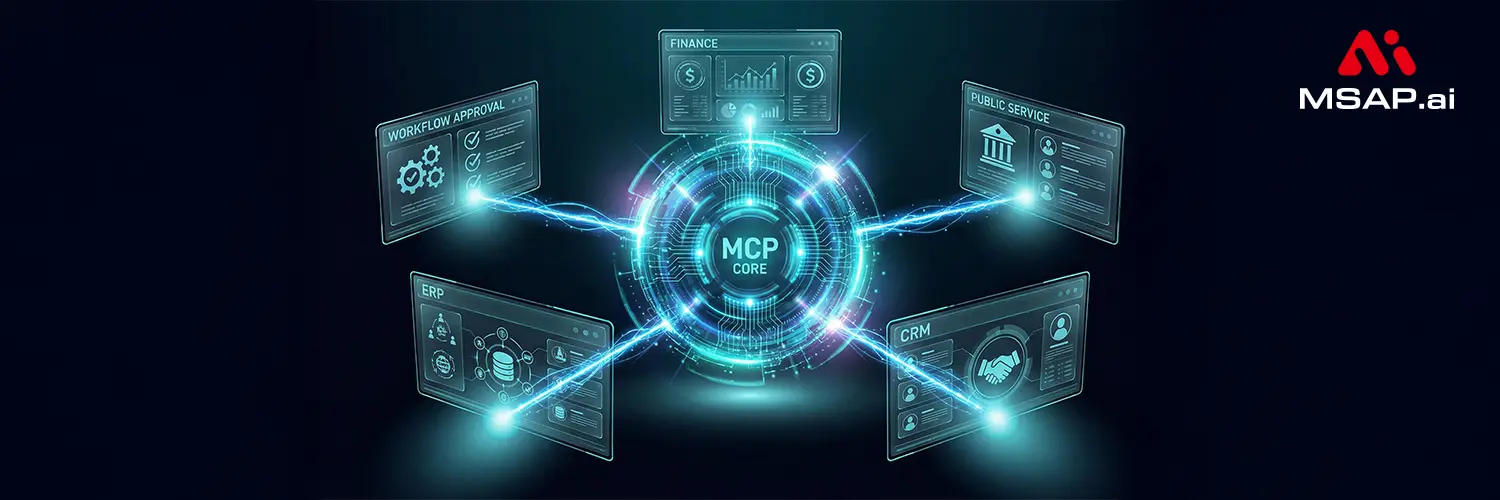

따라서 기업의 AI 성숙도를 보여주는 진짜 지표는 “GPU 몇 장인가?”가 아니라 “AI가 직접 호출해 실행할 수 있는 업무 기능(=MCP)이 몇 개인가?”입니다. 이 백서는 이러한 문제를 단순히 비판하는 데 그치지 않고, AI 인프라 4계층 모델(연산–모델–컨텍스트–애플리케이션) 을 통해 AI가 실제로 업무에 기여하는 과정을 입체적으로 설명합니다.

여기에서 MCP와 RAG가 비즈니스 적용의 핵심 계층임을 강조하며, 기업 내부 업무 시스템과 AI를 연결하는 표준 구조로서 MCP의 역할을 자세히 제시합니다.

이 백서를 읽으면 기업이 어디에서부터 AI 전환을 시작해야 하는지, 그리고 어떤 곳에 먼저 투자해야 실제 ROI를 확보할 수 있는 지가 명확해집니다.

이 백서의 목적 – AI 투자의 관점을 ‘하드웨어 중심’에서 ‘업무 중심’으로 바꾸기

백서는 명확한 목적을 가지고 있습니다.

그 목적은 AI를 둘러싼 투자의 기준을 ‘몇 장의 GPU인가’에서 ‘얼마나 많은 업무를 AI가 실행하도록 만들었는가’로 전환시키는 것입니다.

특히 백서는 공공기관·금융기관·엔터프라이즈 IT 환경에서 다음 질문을 던집니다.

- GPU 투자가 업무 자동화로 이어지지 않는 이유는 무엇인가?

- 왜 LLM 학습이 아니라 추론 활용에 집중해야 하는가?

- 기업이 AI를 활용해 실제 업무 시스템을 지능화하려면 무엇이 필요한가?

- 온프레미스 AI 플랫폼이 공공·금융 환경에서 필수적인 이유는 무엇인가?

그리고 이에 대한 답을 MCP·RAG·온프레미스 LLM 서빙·Observability 통합 구조에서 찾습니다.

이 백서는 단순히 “기술 설명서”가 아니라, 기업이 AI를 도입하는 과정에서 가장 중요한 의사결정 기준을 재정의하는 전략 문서입니다.

백서 목차에 따른 상세 요약

각 내용은 모두 업로드된 백서 원문을 기반으로 작성되었습니다.

제1장 – GPU에서 MCP로: AI 경쟁력의 기준을 바꾸다

백서는 먼저 “GPU 중심의 사고 방식”이 가진 구조적 한계를 지적합니다.

많은 조직에서 AI 도입은 GPU 성능, 모델 크기, 연산 지표에 집중되어 있지만,이러한 지표는 실제 업무 생산성과 직접 연결되지 않습니다.

백서는 이를 명확하게 설명합니다.

- GPU는 모델을 돌리기 위한 ‘연산 기반’일 뿐

- 실제 비즈니스 가치는 모델이 “업무를 실행하는 단계”에서 발생

- 이 실행 단계의 핵심 지표가 바로 MCP 수

즉, AI 활용도를 판단하는 핵심은 연산력이 아니라 AI가 호출할 수 있는 업무 기능의 개수라는 관점을 제시합니다.

제2장 – 엔터프라이즈 AI 인프라 4계층과 온프레미스 AI 플랫폼 전략

이 장은 AI 인프라를 다음 네 계층으로 재정의합니다.

- 연산 계층(GPU/TPU)

- 모델 계층(Foundation Model·도메인 LLM)

- 컨텍스트 계층(MCP·RAG·데이터 커넥터)

- 애플리케이션 계층(챗봇·업무 시스템)

특히 컨텍스트 계층이 AI와 업무 시스템을 잇는 핵심이며,여기서 MCP와 RAG가 핵심 역할을 수행합니다.

또한 공공·금융·엔터프라이즈 환경에서 온프레미스 AI 플랫폼이 필수적인 이유도 설명합니다.

- 데이터 주권과 규제 준수

- 외부 LLM 호출 시 로그·벡터DB에 남는 민감 정보 문제

- 네트워크 지연이 치명적일 수 있는 재난·민원 시스템 특성

온프레미스 LLM 서빙 + MCP + RAG + Observability 통합 구조가 현실적인 AI 도입 전략임을 강조합니다.

제3장 – 왜 ‘모델 학습’이 아니라 ‘추론 활용’에 집중해야 하는가

이 장의 핵심은 명료합니다.

대부분의 기업에게 LLM 학습은 경제적으로 불가능하며, 실제 가치는 추론 활용에 있다.

백서는 다음 근거를 제시합니다.

- Foundation Model 학습 비용은 수천억 원대

- GPU를 늘려도 AI 활용 범위는 자동으로 늘어나지 않음

- 추론 파이프라인은 MSA·API·쿠버네티스 등 기존 엔터프라이즈 기술과 자연스럽게 연결됨

따라서 조직은 모델 학습이 아니라 업무를 MCP 기반으로 AI가 직접 실행하도록 만드는 전략에 집중해야 합니다.

제4장 – MCP의 기술적 정의와 표준 생태계

MCP는 LLM과 외부 시스템 간의 상호작용을 표준화한 개방형 프로토콜입니다.

- JSON-RPC 기반

- 시스템 기능을 AI의 “도구(Tool)”로 추상화

- “N개의 시스템 × M개의 모델” 복잡도를 “1:다” 구조로 단순화

본 장은 MCP의 기술 구조를 깊이 있게 설명하며 왜 MCP가 AI 활용의 필수 인프라인지를 체계적으로 보여줍니다.

제5장 이후 내용 – MCP 기반 AI 도입을 위한 실천 가이드

이 장에서는 실제 조직이 어떻게 MCP 인벤토리를 구축하고

AI 기반 업무 자동화를 확장해 나갈 수 있는지에 대한 구체적인 실행 전략이 제시됩니다.

백서는 다음과 같은 단계를 제안합니다.

- 조직 내 업무 기능을 MCP 후보로 목록화

- 초기 위험이 낮고 효과가 빠른 도메인 선택

- MCP 기반 PoC 수행

- MCP 수·업무 처리 시간 단축률 기반의 KPI 체계 구축

이 단계들을 따라가면 조직 내부의 AI 활용 수준을 체계적으로 성장시킬 수 있습니다.

백서 다운로드를 추천드리는 이유

이 블로그 글은 백서의 핵심 내용을 가능한 한 이해하기 쉽게 정리한 것입니다.

하지만 백서에는 이보다 훨씬 더 풍부한 사례, 실제 공공·금융기관의 RFP 분석, 온프레미스 플랫폼 설계도, MCP 패턴, 성숙도 프레임워크 등이 포함되어 있습니다.

기업 차원의 AI 도입 전략을 고민하신다면 반드시 원문을 다운로드해 정독하시길 추천드립니다.

마무리 – ‘AI가 실행하는 업무의 수’가 기업 경쟁력을 결정합니다

백서는 전체적으로 한 가지 메시지를 일관되게 강조합니다.

AI 시대의 경쟁력은 GPU의 숫자가 아니라 AI가 실제로 실행하는 업무 기능(MCP)의 수다.

기업의 AI 성숙도는 모델의 크기나 파라미터가 아니라

업무 연결성, 도구화된 기능, 컨텍스트 통합 능력에서 판가름납니다.

만약 조직이 지금 AI 도입을 고민하고 있다면 GPU 투자보다 먼저 MCP 인벤토리 구축에 집중해야 합니다.

이 백서는 그 여정을 위한 가장 실질적이고 구조적인 가이드가 될 것입니다.